ROKO

[coursera] Convolutional Neural Networks: Week 4 본문

[coursera] Convolutional Neural Networks: Week 4

RO_KO 2024. 7. 3. 14:39Face verification vs face recognition

Verification

- Input image, name/ID

- Output whether the input image is that if the claimed person

Recognition

- Has a database of K persons

- Get an input image

- Output ID if the image is any of the K persons (or "not recognized")

Reconition이 verification보다 더 어려운 작업이다.

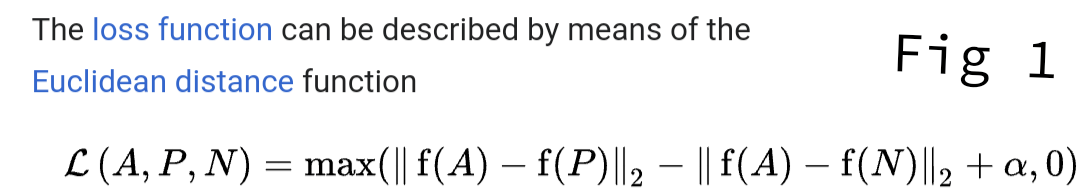

One-shot learning

Learning from one example to recognize the person again.

One-shot learning은 similarity function을 잘 학습하는 것이 목적이다.

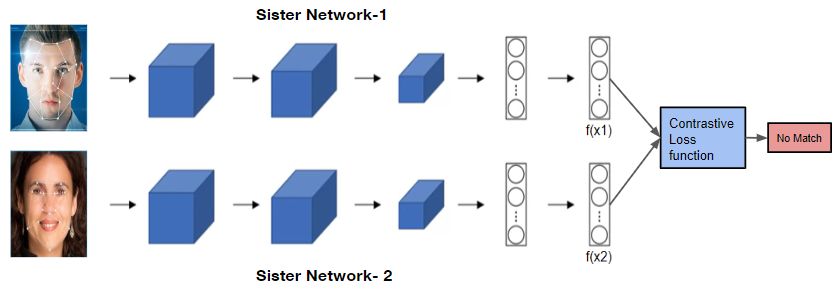

Siamese network

대표적인 모델은 contrastive loss를 활용한 siamese network가 있다.

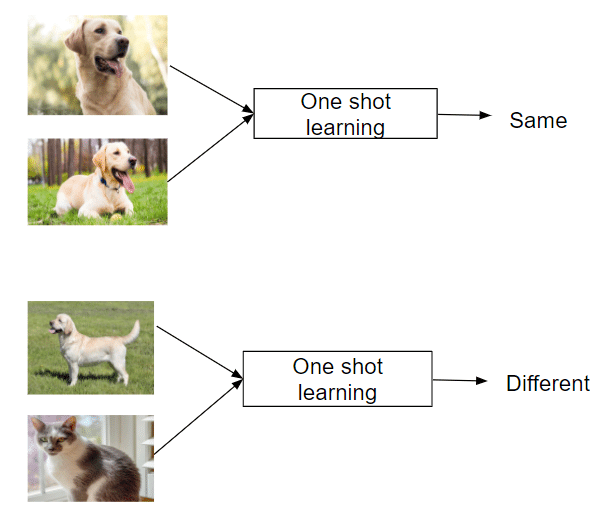

siamese network는 anchor image를 기준으로 postive sample과 negtive sample을 비교해 triplet loss를 구한다.

softmax의 margin과 같은 역하로 \(\alpha\)를 넣어 positve와 negative의 최소 차이를 만들 수 있다. 하지만 sampling 과정에서 random으로 선택할 경우 positive는 이미 많이 닮아있고 negative는 많이 다르기 때문에 모델이 충분히 학습하지 못할 수 있다. 따라서 학습시 모델이 헷갈리만한 이미지 triplet을 선택해주어야 computiational cost를 줄이면서 효율적으로 모델이 학습할 수 있다. 이러한 데이터셋을 구축하는것은 어렵기 때문에 pre-trained된 모델을 활용하는것도 좋은 방법이다.

https://arxiv.org/abs/1503.03832

FaceNet: A Unified Embedding for Face Recognition and Clustering

Despite significant recent advances in the field of face recognition, implementing face verification and recognition efficiently at scale presents serious challenges to current approaches. In this paper we present a system, called FaceNet, that directly le

arxiv.org

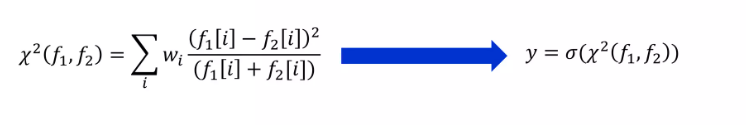

Binary classification

triplet loss가 아닌 다른 방법으로 두 이미지의 embedding을 가지고 같은지 다른지 bianry classification을 학습하며 simiarity function을 얻는 것이다. 효율적인 방식으로 각 이미지들을 저장하는것이 아닌 embedding을 미리 계산해 vector B에 저장하는 방법이 있다.

https://www.cs.toronto.edu/~ranzato/publications/taigman_cvpr14.pdf

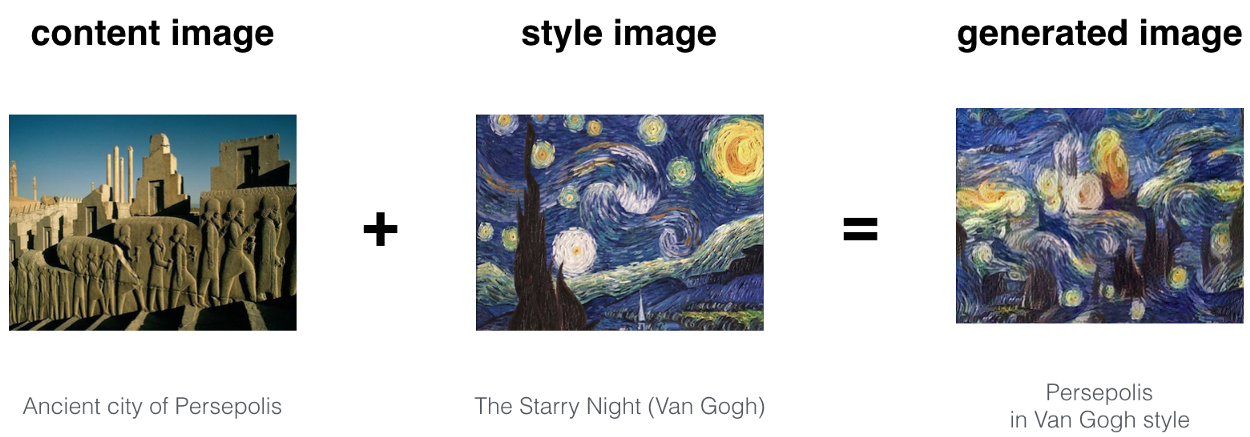

Neural style transfer

https://arxiv.org/abs/1311.2901

Visualizing and Understanding Convolutional Networks

Large Convolutional Network models have recently demonstrated impressive classification performance on the ImageNet benchmark. However there is no clear understanding of why they perform so well, or how they might be improved. In this paper we address both

arxiv.org

각 layer에 hidden unit activation을 크게 만드는 이미지 패치를 시각화한 것이다. layer가 얕을수록 edge와 같은 low level 이미지가 보이고 깊을수록 더 복잡한 high level 이미지가 보이는 것을 알 수 있다.

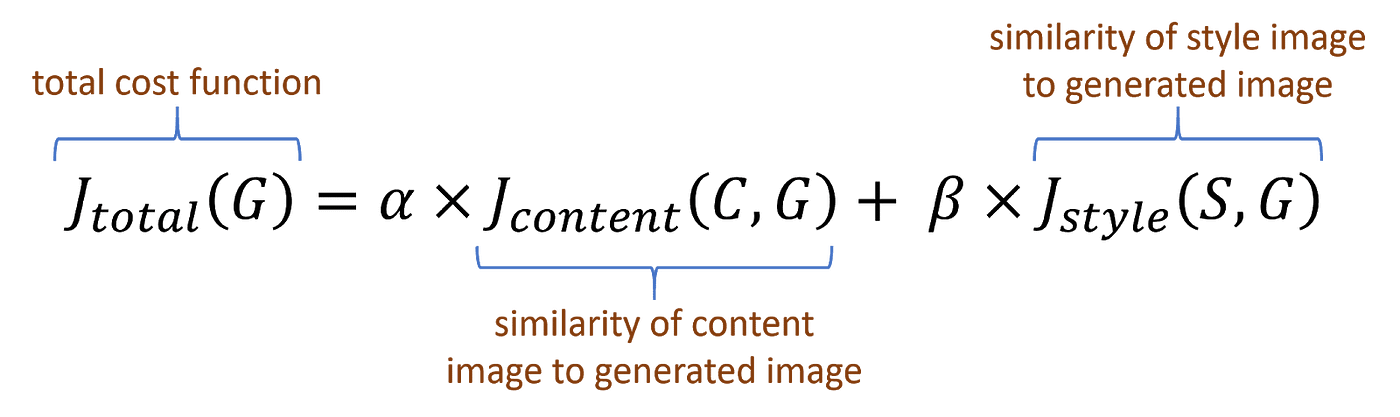

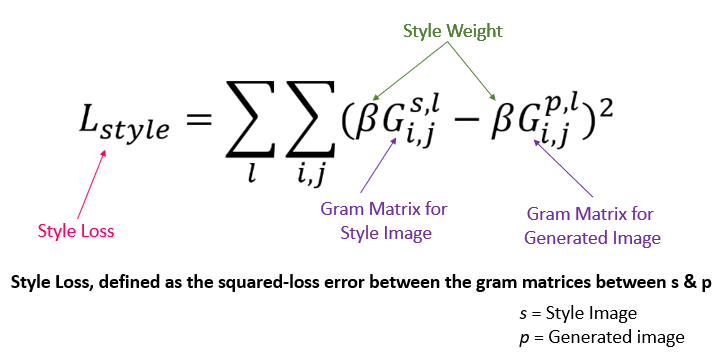

Neural style transfer cost function

https://arxiv.org/abs/1508.06576

A Neural Algorithm of Artistic Style

In fine art, especially painting, humans have mastered the skill to create unique visual experiences through composing a complex interplay between the content and style of an image. Thus far the algorithmic basis of this process is unknown and there exists

arxiv.org

Content cost function

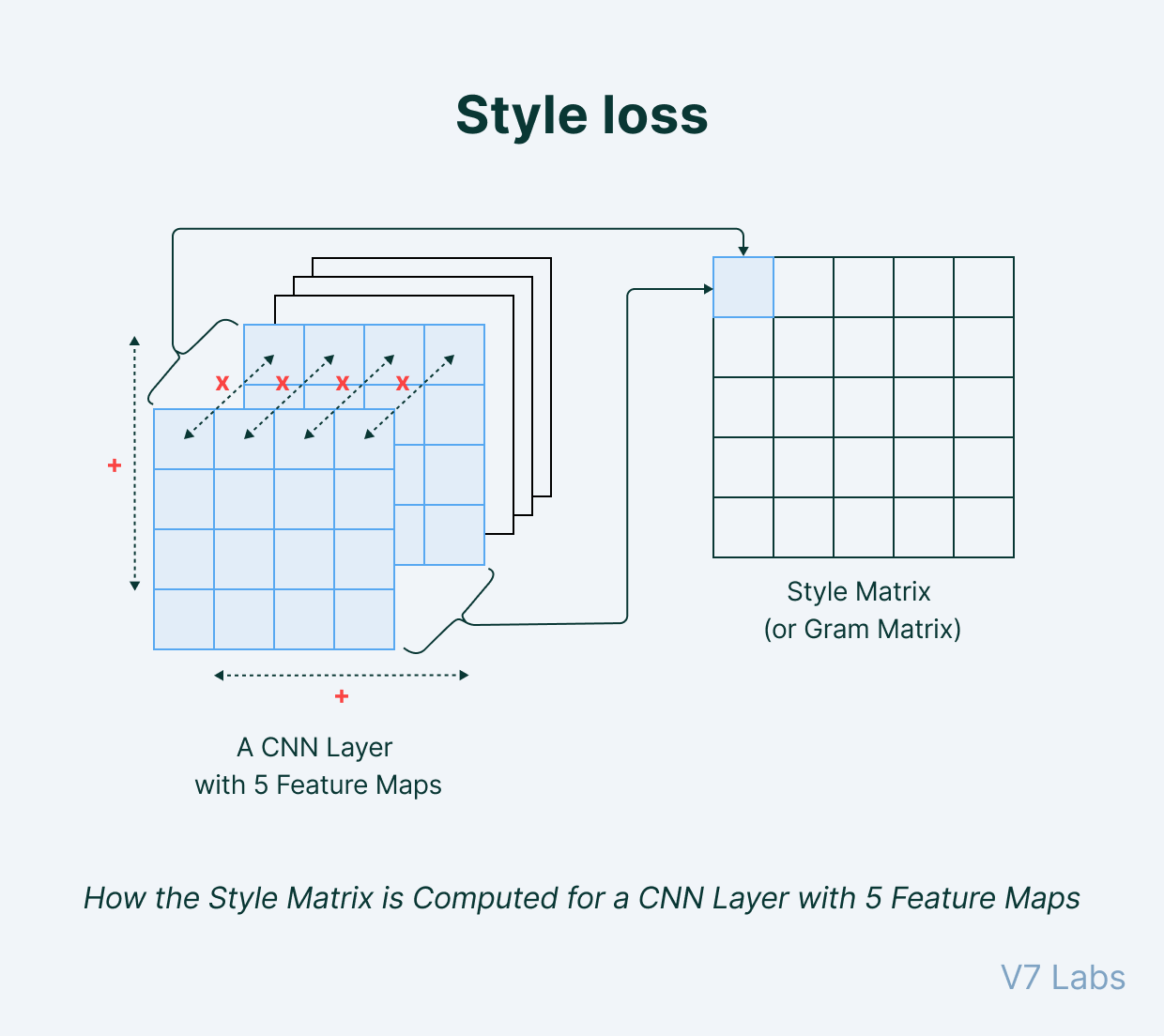

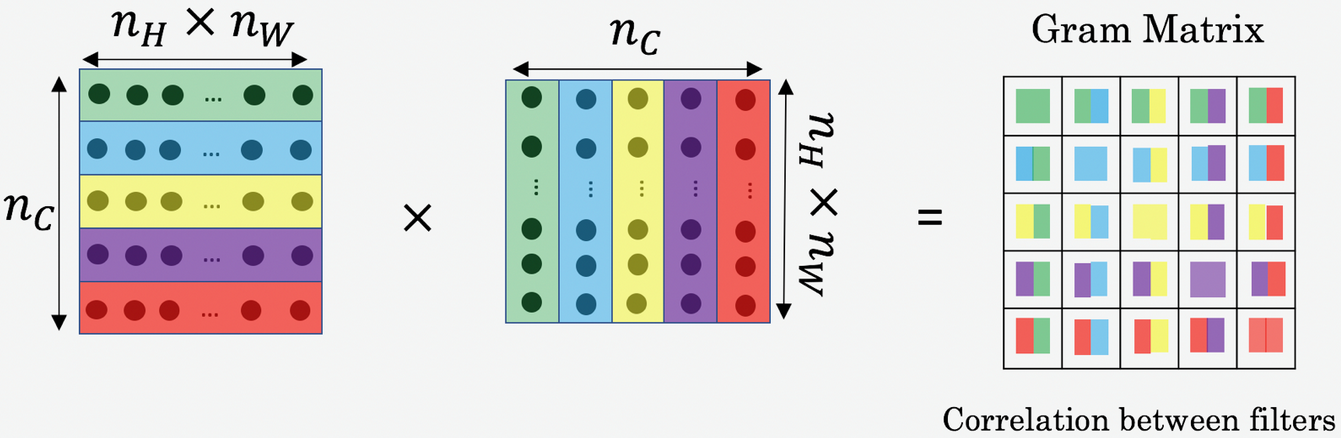

Style of image

'Artificial Intelligence > Deep Learning' 카테고리의 다른 글

| [coursera] Sequence Models: Week 2 (0) | 2024.07.09 |

|---|---|

| [coursera] Sequence Models: Week 1 (0) | 2024.07.03 |

| [coursera] Convolutional Neural Networks: Week 3-2 (0) | 2024.07.03 |

| [coursera] Convolutional Neural Networks: Week 3-1 (0) | 2024.07.03 |